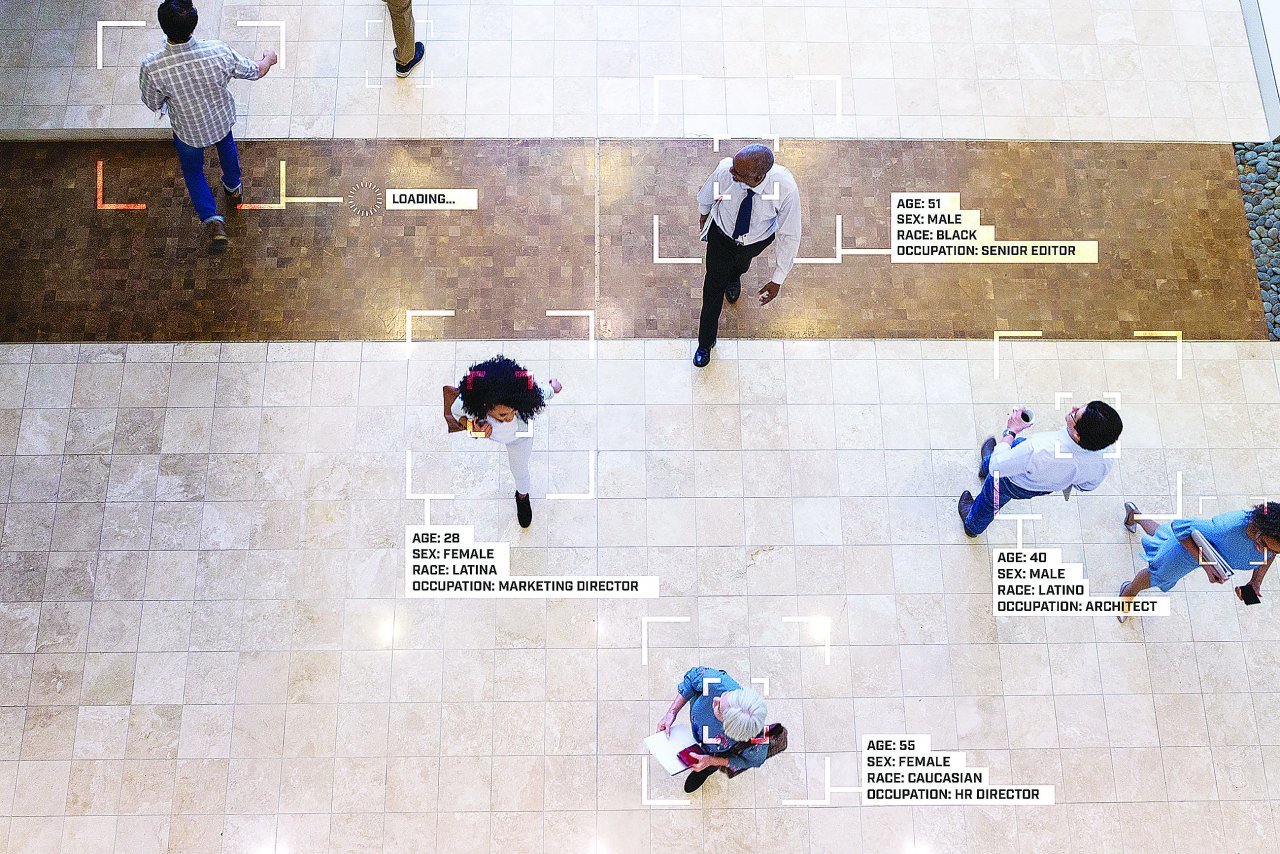

Tecnologia e sicurezza. Una faccia, una persona?

Polizie e governi in tutto il mondo li usano, ma gli studi sembrano dimostrare come i sistemi di riconoscimento del viso siano spesso imprecisi e discriminatori

Di Federica Cameroni

Pubblichiamo un contributo apparso su Ticino7, allegato a laRegione.

È una tecnologia di Intelligenza Artificiale (o A.I.) che potremmo definire l’evoluzione dei sistemi di rilevamento del volto. Quelli capaci di catturare i punti nodali del viso, trasformarli in dati, e, agganciandosi a un algoritmo, correggere o determinare alcuni fattori (gli occhi rossi nelle fotografie o sbloccare l’iPhone). Il riconoscimento facciale, in più, fa un’analisi: confronta e abbina i dati catturati ad altri dati in un archivio, per identificare persone o fornire previsioni sui loro comportamenti. La discriminazione, invece, è insita nella natura degli algoritmi.

In fase di addestramento l’algoritmo viene istruito con degli esempi (set di dati), selezionati da un essere umano in base ai suoi criteri di “risposta giusta” che difficilmente sarà esente da pregiudizio. Finita la supervisione le macchine fagocitano dati; gli algoritmi si affinano a ogni utilizzo. Così gli stereotipi che li hanno istruiti. Immaginiamo un algoritmo per identificare sospetti di crimini dove, in fase di addestramento, gli esempi presentino un numero sproporzionato di immagini di persone appartenenti a una minoranza etnica. I loro tratti somatici saranno meccanicamente considerati un buon criterio per identificare un sospetto. Fra il 2019 e il 2020 negli USA, arresti ingiustificati dovuti a errori al riconoscimento facciale sono già avvenuti: Robert Williams, Nijeer Parks e Michael Oliver. Tutti e tre afroamericani.

Errori e discriminazioni

Joy Buolamwini nel 2018 nello studio Gender Shades dimostra come alcuni dei sistemi di riconoscimento facciale più venduti (quelli di IBM, Microsoft e Face++) sbagliassero dell’1% nell’identificazione di uomini bianchi e del 34,4% nel caso di donne non bianche. Inoltre si basavano su un’idea binaria di genere limitata a uomo/donna. Nel 2019 il National Institute of Standards and Technology (agenzia governativa USA) ha analizzato 189 algoritmi, sebbene la precisione variasse; tutti tendevano a sbagliare di più nell’identificazione di persone asiatiche o afroamericane. È stata riscontrata la medesima problematica con i software di Google, Facebook, Amazon. Quasi tutte le aziende hanno annunciato la correzione delle falle o la soppressione delle vendite alle forze dell’ordine. L’associazione statunitense Fight for the Future ritiene siano strategie di comunicazione, siccome i loro sistemi sono stati venduti a numerose altre autorità di vigilanza. Nel Regno Unito il riconoscimento facciale è stato frequentemente sperimentato su richiesta della polizia (musei, aree pubbliche, centri commerciali…); l’organizzazione Big Brother Watch sostiene che i software della polizia di Londra arrivino al 98% di falsi positivi.

I set di dati devono essere ampi, quasi per forza ci si andrà a riferire a un arco temporale vasto. Modellando le macchine sul passato le discriminazioni, anziché superate, vengono codificate rischiando di robotizzare problemi come il razzismo o il sessismo. Nel 2018 Amazon ha rinunciato a un sistema dedicato alle assunzioni poiché sessista. L’algoritmo, addestrato su modelli passati e relativi a decenni in cui l’accesso agli studi era precluso alle donne, finiva per scartare i curricula femminili. Nell’articolo “Monitoring hiring discrimination through online recruitment platforms” pubblicato su Nature, tramite un metodo di monitoraggio combinato (comportamento dei reclutatori e dell’apprendimento automatico) è stata analizzata la piattaforma svizzera di reclutamento online del servizio pubblico: i tassi di contatto risultano inferiori del 4-19% per gli individui di gruppi etnici minoritari a dipendenza del paese di origine; 7% in meno per le donne nei settori considerati maschili (uguale per gli uomini nei settori considerati femminili).

© iStockphoto

Sorveglianza intelligente

Un rapporto dell’organizzazione no profit Corporate Europe Observatory rileva: “Una tendenza preoccupante dell’UE per cui alle aziende di armi, sorveglianza e biometria viene assegnato un ruolo fuori misura”. Sarebbero 108 le entità incontrate dall’UE per discutere di “biometria, intelligence marittima, rilevatori di battito cardiaco e sistemi di ispezione documenti”. “iBorderCtrl” (Intelligent Portable Border Control System) è un progetto di analisi dei movimenti facciali volto a velocizzare il lavoro delle guardie di frontiera. È stato finanziato dal programma della Commissione Europea ‘Horizon 2020’ e sperimentato tra il 2016 e il 2019 ai confini di Ungheria, Lettonia e Grecia. Al riconoscimento facciale è abbinato un algoritmo per identificare le emozioni di chi parla. Una macchina della verità. Imprecisa, secondo i giornalisti che l’hanno testata. In seguito alla denuncia dell’europarlamentare tedesco Patrick Breyer, la società è stata sottoposta a un’audizione davanti alla Corte di Giustizia. In un documento ottenuto da Breyer (“Piano di diffusione e Comunicazione”), l’azienda sostiene sia meglio tenere la popolazione all’oscuro: “Il dibattito pubblico potrebbe ostacolare l’attuazione delle politiche necessarie per IBorderCtrl”. Frase che, con altre simili, era stata oscurata “per ragioni di privacy aziendale” e che l’europarlamentare ha rintracciato con l’aiuto di un esperto.

Dal governo cinese il riconoscimento facciale viene usato per disincentivare gli incidenti stradali, proiettando su schermo volto e nominativi di chi infrange il codice; identificare i manifestanti di Hong Kong (attraverso lampioni intelligenti) o monitorare la minoranza degli Uiguri tramite droni (programma ‘Dove’). La Cina è poi sede di sperimentazioni distopiche e “intelligenti”: la polizia con gli occhiali “acuti”, capaci di identificare le persone (Sharp Eyes); il riconoscimento emozionale con cui stabilire il tasso d’attenzione degli studenti o la produttività degli impiegati; finendo con il “punteggio sociale”, già sperimentato in alcune zone. Un sistema di bonus/malus a livelli, scalabili a dipendenza della condotta sociale.

Troppa invadenza

Il 26 gennaio Amnesty International ha lanciato a New York, con intenzione di estenderla nel mondo, la campagna ‘Ban the Scan’ per impedire i sistemi di videosorveglianza legati al riconoscimento facciale, definiti: “Una tecnologia intrusiva che usa la nostra identità come arma contro di noi”. Il divieto è già in atto in alcune città degli Stati Uniti. La Commissione Europea il 21 aprile ha presentato un piano per regolamentare l’uso di Intelligenza Artificiale, identificando quattro livelli di rischio. Il riconoscimento biometrico rientra nella categoria “alto rischio” se al di fuori del contesto delle forze dell’ordine, per le quali è inaccettabile, “se utilizzato in tempo reale e in luoghi pubblici”. Al divieto sono previste eccezioni (cercare vittime, contrastare il terrorismo ecc.). Il Centro Hermes per i diritti digitali sostiene che la proposta si contraddica e non sia abbastanza. Il Garante europeo della protezione dei dati ritiene necessario un approccio più rigoroso per evitare “rischi elevati di intrusione non democratica”. La Svizzera, sede di numerose Startup e istituti di ricerca di Intelligenza Artificiale, a novembre 2020 ha definito le linee guida per regolamentarne l’uso, fra cui: centralità dell’essere umano, sicurezza, trasparenza e assunzione di responsabilità.

© iStockphoto

CHE SUCCEDE IN SVIZZERA?

Clearview a.i è un software di riconoscimento facciale, inizialmente offerto gratuitamente per un periodo di prova ai dipendenti di vari enti e autorità negli USA. Non è nota la precisione perché nessuna terza parte l’ha verificato, l’azienda dichiara il 99% d’accuratezza. Come riporta il New York Times nel database, contenente più di tre miliardi d’immagini, erano presenti fotografie prese senza consenso dai Social Network e dal web, riguardanti cittadini di tutto il mondo. Svizzeri compresi. L’incaricato federale della protezione dei dati e della trasparenza (IFPDT) a febbraio 2020 ha raccomandato alle autorità di vigilanza di non usare Clearview, le quali hanno confermato di non averlo mai utilizzato; Clearview non ha ancora risposto alla richiesta di cancellazione dei dati dei cittadini svizzeri.

Alle mie domande sul riconoscimento facciale in tempo reale, l’IFPDT risponde che mette “a rischio diversi principi fondamentali della protezione dei dati”, fra cui trasparenza, cioè consenso informato; proporzionalità, utilizzare un altro sistema laddove fosse possibile e finalità, non utilizzare i dati per scopi diversi da quelli dichiarati: “Le persone o aziende private che intendono utilizzare tale tecnologia sono responsabili che questi principi siano rispettati”, i principi sono esplicitati nell’articolo 4 della Legge Protezione Dati (LPD): “Se la polizia o un’altra autorità federale volesse adoperarla, ci vorrebbe una base legale a giustificarlo”. Tuttavia: “A nostra conoscenza, questa tecnologia non viene utilizzata da parte di privati o aziende con sede in Svizzera.

Le autorità federali di polizia hanno confermato nel marzo 2020 che non utilizzano software di riconoscimento facciale”. Secondo un articolo di Der Bund di questo aprile, in Canton Argovia, la polizia ne fa uso: “Le polizie cantonali sottostanno però alla vigilanza delle autorità cantonali per la protezione dei dati”. La polizia cantonale ticinese afferma: “Attualmente non viene fatto capo a sistemi di riconoscimento facciale”. Lo stesso dice il Dipartimento federale della difesa, della protezione della popolazione e dello sport: né l’esercito né il Servizio delle attività Informative della Confederazione (SIC) utilizzano questa tecnologia e l’interesse nella digitalizzazione non riguarda sistemi di decisione automatizzata. Un po’ diversamente risponde FedPol: “Questa tecnologia è già usata da diverse autorità di sicurezza, per esempio all’aeroporto di Zurigo per l’identificazione

e dalla polizia svizzera romanda per indagare su reati”.